[Je m'étais fixé

l'objectif de publier cette revue de lecture en Juin, la voici! Après lecture du billet ci-dessous,

cette vidéo est à revoir]

Chris Anderson a publié en Juin

son livre "The Long Tail" issu de la poursuite d'

un article séminal paru en Octobre 2004 dans le magazine Wired (pour lequel il travaille). InternetActu a traduit cet article "The Long Tail" en

"La Longue Traîne" (sûrement moins suggestif que leur choix initial de "La Longue Queue ;-)…). J'utiliserai donc "La Longue Traîne".

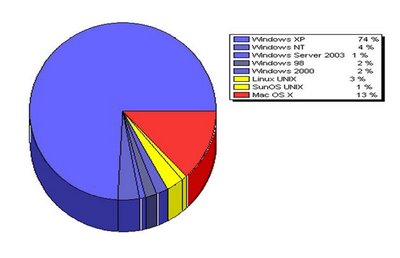

Selon le livre, la quintessence de "Longue Traîne" est le passage du monde commercial et culturel de la rareté (contraint par les limites logistiques du monde physique) à celui de l'abondance, libéré par l'Internet, le commerce électronique et la digitalisation des médias. Elle apporte un nouveau modèle économique (mais aussi socio-culturel) permis par l'ubiquité de l'Internet (présent maintenant

chez tout le monde ou presque … et

en haut débit) qui permet donc aux producteurs de biens ou de contenus de nous exposer (i.e via les sites web de e-commerce = les catalogues papier d'antan version 2006) à tous leurs biens et services avec un niveau de coût incroyablement bas (jamais atteint jusqu'à présent).

De plus, pour les producteurs et distributeurs de contenus culturels (musique, textes, vidéos, etc…), un deuxième niveau d'économie est atteint dans la distribution même du contenu qui circule lui-même par le réseau car il est maintenant abondamment numérisé (blogs textuels,

podcasts et

musiques mp3, films et vidéos

divx, etc…)

C. Anderson s'accorde la paternité de la structuration du concept de Longue Traîne depuis 2004 mais certainement pas la vision pionnière de ses avantages économiques. Il l'attribue à

Jeff Bezos, fondateur et ceo actuel d'

Amazon. C'est J. Bezos qui selon C. Anderson a perçu en premier les nouvelles possibilités économiques et le potentiel de cette longue traîne.

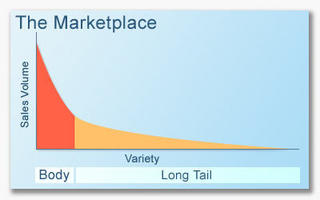

Quelle est-elle, cette Longue Traîne? Pour C. Anderson, c'est le fait que nous sommes en train de passer du marché de masse ("mass market") où le top 50, les best-sellers du livre et les blockbusters du cinéma règnent à un marché composé de millions de niches où les choix très éclectiques des consommateurs se répartissent sur des multitudes de titres. Selon C. Anderson, J. Bezos a perçu en premier comment l'Internet permettait l'agrégation profitable de ces niches.

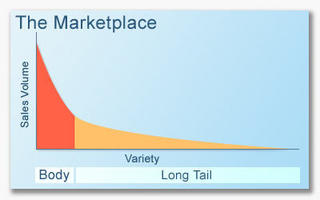

En mathématique, la longue traîne est une

loi de puissance: la demande pour un produit est une fonction exponentielle décroissante du rang de classement de ce produit dans la demande globale. Sous forme graphique, cela donne:

Cette courbe descend donc de manière asymptotique vers le zéro sans jamais le toucher. L'objectif des sociétés basées sur cette Longue Traîne comme Amazon est de monétiser (avec des profits…) la zone de demande où celle-ci est tellement faible qu'aucune rentabilité ne pouvait être envisagée avant l'Internet (i.e le côté droit de la courbe ci-dessus).

Dans le domaine culture, deux caractéristiques de cette longue traîne culturelle sont actuellement modifiées sous l'influence du Web :

- sa "longueur" (le nombre de "produits" disponibles) car nous pouvons tous nous mettre à "composer" à la maison avec des équipements d'un prix ridiculement bas des produits (culturels)

- son "épaisseur" (la demande pour ces produits) car les amateurs diffusent leur consommation sur un plus grand nombre de titres que les seuls hits du passé (les seuls choix possibles de l'époque!…)

La longue traîne s'appuie essentiellement sur 3 leviers:

- des outils matériels et logiciels à très bas prix (voire gratuits avec les Logiciels Libres) qui permettent à tout un chacun de fabriquer sans barrière financière des œuvres personnelles qui allongent cette longue traîne

- l'ubiquité de l'Internet qui permet de réduire les coûts de promotion puis de distribution de ces oeuvres

- les systèmes de recommandation multiples (réponses Google sélectionnées par le Pagerank, filtrage collaboratif et revues de lectures sur Amazon, tagging dans les folksonomies comme del.icio.us, etc…) qui font que les consommateurs osent explorer la partie postérieure de la traîne en partant des hits de la tête: le cas du livre X de l'article initial en est un excellent exemple

C. Anderson insiste sur l'importance de ces systèmes de recommandation en rappelant le flop du site MP3.com qui est mort très rapidement. Il avait eu le tort de vouloir ne vivre que de la queue de cette longue traîne. Or, la qualité dans cette queue est très inégale (beaucoup plus que dans la tête) et statistiquement on a donc plus de chances de tomber sur du mauvais que sur du bon dans la queue (sachant en plus que "bon" et "mauvais" sont des valeurs subjectives très dépendantes des intérêts et de la personnalité de chacun).

Un service "Longue Traîne" doit donc s'appuyer sur des recommandations associatives (le filtrage collaboratif d'Amazon comme excellent exemple): mp3.com est donc mort car il voulait ne vivre que de la commercialisation de la musique indépendante d'une qualité très variable. Ne pouvant faire "démarrer" les utilisateurs de son site par des hits standards pour ensuite progresser par association vers des équivalents moins connus, les utilisateurs fuyaient rapidement car ils tombaient majoritairement sur les "croûtes".

Pour insister sur l'importance de ces filtres de recommandation, C. Anderson complète le tableau par des études psychologiques prouvant l'importance des recommandations pour un consommateur: sans aide et devant une multitude choix, il finit par fuir plutôt que de risquer le mauvais achat!

En synthèse, cette Longue Traîne n'est finalement que la poursuite (grâce à de nouvelles technologies d'un phénomène engagé depuis des siècles: la création de nouvelles sociétés commerciales basées sur l'émergence de technologies innovantes qui réduisent toujours plus les coûts de production et de promotion/distribution. C'est donc toujours la destruction créatrice de J. Schumpeter (

autre exemple ici) en pleine action!

Il faut ajouter à ceci une autre dimension: la "sagesse de foules" ("The Wisdom of Crowds)" qui est soit directement (revues dans Amazon) soit indirectement (Pagerank Google d'une page progressivement amélioré par des liens depuis d'autres sites) mise en action pour fabriquer ces systèmes de recommandation. Ces derniers ne peuvent être de qualité que grâce à l'ubiquité de l'Internet puisqu'il faut un grand nombre de contributeurs pour que ces recommandations deviennent statistiquement valides.

Enfin, C. Anderson considère que nous avons déjà vécu deux étapes dans la Longue Traîne:

- "l'étape Amazon" où le libraire en ligne n'a (dans son modèle initial) a profité des avantages de l'Internet seulement pour réduire les coûts de promotion et faciliter les transactions de vente de produits "exotiques" qui ne peuvent être vendus en magasins de détails car leur niche est trop étroite.

- l'étape Apple avec son Itunes où le produit lui-même est devenu numérique et peut donc être "produit à la maison" puis distribué par Internet à des coûts ridicules (souvent nuls hormis le temps de l'auteur). Cela donne une chance à des produits encore plus exotiques de trouver leurs niches et la Traîne s'allonge d'autant!

L'étape Apple/Itunes pousse le modèle à son extrême car alors la rentabilité financière atomique (i.e. par unité) finale d'un produit est la même qu'il soit au Top50 ou quasi-inconnu. La valorisation économique de la queue de la Longue Traîne fait alors beaucoup de sens!

L'étape Apple/Itunes pousse le modèle à son extrême car alors la rentabilité financière atomique (i.e. par unité) finale d'un produit est la même qu'il soit au Top50 ou quasi-inconnu. La valorisation économique de la queue de la Longue Tra'ine fait alors beaucoup de sens!

La question fondamentale qui reste ouverte pour l'instant est le volume financier réel de cette traîne de : ainsi que le note B. Giussani, C. Anderson est revenu en arrière après 2 ans d'études détaillées sur ces annonces par rapport à ce volume: il disait initialement dans l'article Wired que la partie postérieure, celle qui est inexploitée dans le monde physique à cause de taille limitée des rayons des magasins représentait un business supérieur à la tête. Maintenant, il dit seulement que la partie postérieure de la Longue Traîne est appelée à devenir "un marché significatif".

De toute façon, la valeur économique globale de cette longue traîne reste à évaluer: Amazon, Google, Netflix, iTunes ne sont encore que épiphénomènes très récents dans leurs branches respectives. Jusqu'où les mutations actuelles de forme (allongement et épaississement de cette longue traîne pourront-ils aller sachant que les ressources financières des consommateurs restent identiques et que l'être humain est une espèce fondamentalement grégaire donc qui gardera quand même finalement son instinct "troupeau" pour (une partie de) ses choix culturels?

Là où la Longue Traîne va sûrement prospérer pendant encore longtemps, c'est sûrement dans le domaine de la culture gratuite ("Free Culture" évangélisée par Larry Lessig): la croissance explosive de la blogosphère depuis 3 ans en est sûrement la meilleure preuve. Et cela, même si pour beaucoup, la culture gratuite en queue de traîne n'est que la première étape obligée pour une progression à but lucratif vers l'avant de la Traîne….

Le chapitre 10 est intéressant pour faire la synthèse des conditions d'émergence puis de succès de cette Longue Traîne. En synthèse, pour C. Anderson, il faut "rendre tout disponible" puis aider "le consommateur à trouver". En détaillant un peu plus, il dit qu'il faut

- réduire ses coûts (a) en faisant levier sur les formes les plus modernes (logistiques ou financières) de gestion des inventaires et (b) en laissant au maximum les clients "faire le boulot" (tiens, la fameuse composante sociale du web 2.0 présentée sous sa forme lucrative….)

- penser niche en offrant toutes les formes de distribution possibles, tous les produits possibles, toutes les formes de facturation raisonnables

- apprendre à "perdre le contrôle" en offrant toutes possibilités (en tout cas un maximum!) et en laissant le client choisir ensuite. Pour transférer ce contrôle vers le client, il faut le munir de toutes les informations dont on dispose. Ce sera ensuite le marché qui fera le travail de sélection (... pré-recommandation en quelque sorte) réalisé actuellement en amont par les commerçants.

- comprendre et utiliser le "Force du Gratuit" ("Power of Free"): on offre le gratuit à tous (vu les coûts marginaux très faibles d'un utilisateur supplémentaire) et on convertit seulement une fraction en clients payants: ils suffisent à devenir rentable (cf Skype avec son générateur de revenus SkypeOut)

J'ai beaucoup appris ou recadré de choses dans mon esprit en lisant ce livre particulièrement bien structuré. Après lecture, on a une bonne vision historique complète de l'optimisation permanente des processus commerciaux depuis l'émergence de la vente par catalogue par Sears & Robuck jusqu'au succès de iTunes.

J'espère cependant que cet ouvrage aura une seconde édition ou une suite dans quelques temps pour reprendre la partie économique qui ne bénéficie pas encore d'un recul suffisant: on est encore à l'aube du phénomène et il n'est essentiellement mesuré que le marché US. Il semble donc plein d'opportunités dont ne peut évaluer la taille commerciale réelle. D'ici à 5 ans, on commencera à en mesurer réellement l'ampleur même si les générations nées avec l'Internet ne représenteront encore qu'un fragment de la population.

Je recommande fortement la lecture de ce livre: il va à mon avis rester comme l'un des livres "business" forts de ces prochaines années ! Il décrit en effet un phénomène appelé à se généraliser (industries et géographie) et à fortement modifier l'économie des sociétés ainsi que la vie des citoyens si son ampleur se confirme.

… mon seul - petit - regret (Il en faut bien un pour ne pas être taxé de complaisance aveugle!): des passages sont à mon avis hors sujet ou trop peu argumentés comme

- la collaboration grâce à Internet entre astronomes amateurs et professionnels

- la longue digression sur la perplexité des consommateurs face à un choix trop abondant de confitures dans leur supermarché

- la longue traîne de la bière ou des farines dans les supermarchés

Mais, finalement, lisez ce livre: il en vaut franchement la peine!

Aussi votre avis?

PS: l'ultime paradoxe pour ce livre, c'est qu'il

est dans le Top10 des best-sellers du New-York Times aux USA! ;-))

Source: blog

Media & Tech (par didier durand)