J'avais prédit hier un haro sur Google parce qu'il permet le téléchargement gratuit de livres classiques dont les droits d'auteurs sont tombés.

Il n'a pas tardé: Olivier Ertzcheid - qui dans son billet très fouillé détaille aussi toutes les conditions du deal entre Google et les universités américaines - nous livre son point de vue d'universitaire français qui pense que c'est un marché de dupes.

Il écrit: "Au final le marché de dupe est le suivant : chacun des 2 partenaires reçoit "sa" copie, une copie à usage interne si l'on veut. Mais le marchand (Google) s'ouvre tous les droits sur la sienne et les copies de la sienne (impression, téléchargement, revente ...) et impose au bibliothécaire un usage fermé et stérile de la sienne (pas de revente ni de cession, pas de téléchargement depuis les sites universitaires, etc.). Une forme revendiquée d'eugénisme documentaire.

On appréciera le cynisme du billet annonçant la nouvelle sur le blog de Google : "Now, with the help of our wonderful library partners, we're able to offer you the ability to download and read PDF versions" ...

Chaque nouvelle bibliothèque contractante, en même temps qu'elle assure une visibilité de ses fonds et à l'impression de contribuer à la dissémination mondiale de la culture, fait faire un irrémédiable pas en arrière de plus à l'ambition d'une bibliothèque universelle.

Et pour parachever le tout, nos chères bibliothèques n'ont d'autre choix que d'accepter le cadeau "empoisonné" de Google qui consiste à opter pour une solution hébergé, le temps de la numérisation : c'est à dire que les oeuvres seront disponibles sur le site de Google uniquement, le temps que les université aient mis en place les capacités de stockage et de bande passante nécessaires ... "

Pas tendre, Olivier, mais sûrement très réaliste sur beaucoup de ses arguments!

Le débat va être brûlant mais passionnant: sur le fond, il dépasse très largement le sujet Google Books pour poser de grandes questions de société sur le rôle de nos institutions académiques, l'utilisation commerciale des biens publics, etc...

Nous vivons vraiment une époque très spéciale dans notre Histoire!

Source: blog Media & Tech (par didier durand)

jeudi, août 31, 2006

mercredi, août 30, 2006

Prochain haro sur Google Books? Des livres complets (hors droits) téléchargeables gratuitement

Google est dans une quête perpétuelle pour la maximisation du contenu (gratuit) de son index et disponible sur Internet en général. L'objectif est clair: maximiser les espaces publicitaires collatéraux à ces contenus afin d'avoir un maximum d'exposition pour ses publicités Adwords/AdSense en mode pay-per-click qui sont au coeur de sa stratégie (voir le graphique de ce billet)

Constatant qu'un immense contenu se trouvait dans les livres non accessibles sur Internet, Google (copié par Yahoo et Microsoft unis dans l'Open Content Alliance - OCA) a entrepris dès 2004 de les digitaliser: c'est le service Google Print renommé Google Books (voir le site français) en chemin.

Dans cette croisade, il a créé depuis longtemps des différends avec les éditeurs car cette quête du contenu universel gratuit est clairement et souvent en opposition avec les intérêts des maisons d'édition.

Celles-ci le lui rappellent souvent: en France, le dernier exemple en date est le procès des éditions de La Martinière contre Google Books pour violation des droits d'auteurs. Il suit de multiples péripéties juridiques avec les auteurs et éditeurs américains (sans parler du procès AFP autour des dépêches en ligne...)

Mais, aujourd'hui Google frappe très fort: la BBC annonce qu'il va proposer gratuitement le téléchargement en ligne de livres complets (format PDF issu de la numérisation) pour lesquels les droits d'auteurs sont tombés. Le blog principal de Google et celui dédié à Google Books confirment chacun la nouvelle.

[Exemple: une traduction anglaise de l'Enfer (La Divine Comédie) de Dante de 1833 - le livre complet en PDF est accessible sur cette page (le petit bouton "Download" donne accès aux 437 pages du livre intégral pour 5.1 Moctets seulement!)]

Sachant que les droits ne durent que quelques dizaines d'années (le "quelques" étant variable selon les pays), cela va donner un accès gratuit à des millions de livres à Mr Tout Le Monde depuis son PC. Cela veut dire par exemple Molière, La Fontaine, Jean-Jacques Rousseau, Platon, etc... accessibles sur chaque PC de la planète

Mon coeur balance:

Autant Google pouvait plus ou moins "se les mettre dans la poche" en partageant les revenus Adwords de Google Books et en générant des leads pour ces livres vers Amazon ou Alapage.com mais là, il va avoir du mal à expliquer qu'il n'est pas en train de scier la branche sur laquelle ils sont assis!

De toute façon, je ne comprends pas ce mouvement de Google par rapport à la stratégie évoquée en préambule: en quoi cela augmente-t-il l'activité de recherche sur son moteur et les espaces publicitaires correspondants? Au contraire....

Pour boucler sur une note positive, les marchands d'imprimantes PC et de consommables peuvent se frotter les mains ! Ce que l'on appelait encore humoristiquement le "copillage" récemment va exploser....

Source: blog Media & Tech (par didier durand)

Constatant qu'un immense contenu se trouvait dans les livres non accessibles sur Internet, Google (copié par Yahoo et Microsoft unis dans l'Open Content Alliance - OCA) a entrepris dès 2004 de les digitaliser: c'est le service Google Print renommé Google Books (voir le site français) en chemin.

Dans cette croisade, il a créé depuis longtemps des différends avec les éditeurs car cette quête du contenu universel gratuit est clairement et souvent en opposition avec les intérêts des maisons d'édition.

Celles-ci le lui rappellent souvent: en France, le dernier exemple en date est le procès des éditions de La Martinière contre Google Books pour violation des droits d'auteurs. Il suit de multiples péripéties juridiques avec les auteurs et éditeurs américains (sans parler du procès AFP autour des dépêches en ligne...)

Mais, aujourd'hui Google frappe très fort: la BBC annonce qu'il va proposer gratuitement le téléchargement en ligne de livres complets (format PDF issu de la numérisation) pour lesquels les droits d'auteurs sont tombés. Le blog principal de Google et celui dédié à Google Books confirment chacun la nouvelle.

[Exemple: une traduction anglaise de l'Enfer (La Divine Comédie) de Dante de 1833 - le livre complet en PDF est accessible sur cette page (le petit bouton "Download" donne accès aux 437 pages du livre intégral pour 5.1 Moctets seulement!)]

Sachant que les droits ne durent que quelques dizaines d'années (le "quelques" étant variable selon les pays), cela va donner un accès gratuit à des millions de livres à Mr Tout Le Monde depuis son PC. Cela veut dire par exemple Molière, La Fontaine, Jean-Jacques Rousseau, Platon, etc... accessibles sur chaque PC de la planète

Mon coeur balance:

- c'est très bien pour la diffusion de la culture sur la planète: chaque individu va pouvoir accéder à de tels chefs d'oeuvres. Actuellement, il est sûrement difficile (et coûteux) de trouver des éditions originales d'auteurs classiques hors de leurs pays!

- MAIS, ces classiques hors de droits sont encore commercialisés et font les beaux jours de certaines maisons d'édition et imprimeries. Des drames sociaux en perspective?....

Autant Google pouvait plus ou moins "se les mettre dans la poche" en partageant les revenus Adwords de Google Books et en générant des leads pour ces livres vers Amazon ou Alapage.com mais là, il va avoir du mal à expliquer qu'il n'est pas en train de scier la branche sur laquelle ils sont assis!

De toute façon, je ne comprends pas ce mouvement de Google par rapport à la stratégie évoquée en préambule: en quoi cela augmente-t-il l'activité de recherche sur son moteur et les espaces publicitaires correspondants? Au contraire....

Pour boucler sur une note positive, les marchands d'imprimantes PC et de consommables peuvent se frotter les mains ! Ce que l'on appelait encore humoristiquement le "copillage" récemment va exploser....

Source: blog Media & Tech (par didier durand)

Skype: 7 millions d'utilisateurs simultanés pour son 3ème anniversaire!

Après les caps

Voilà qui

Je suis devenu un bon contributeur au moteur de revenus SkypeOut car je vais largement dépasser les revenus annuels moyens par utilisateur (environ 1.5 dollars/an) de Skype!

Source: blog Media & Tech (par didier durand)

- des 5 millions d'utilisateurs simultanément en ligne le 23 Janvier 2006

- des 6 millions d'utilisateurs simultanément en ligne le 28 Mars 2006

- des 100 millions de comptes utilisateurs enregistrés le 1er Mai (et 115 millions vers fin Juillet)

Voilà qui

- devrait faire rêver ou trembler beaucoup d'opérateurs historiques de téléphonie (Skype leur fait déjà perdre 1 milliard par an au (très) bas mot)

- annonce de beaux jours à la téléphonie click-to-call dans le cadre du deal récemment signé entre EBay/Skype et Google (qui possède des brevets sur le sujet)

Je suis devenu un bon contributeur au moteur de revenus SkypeOut car je vais largement dépasser les revenus annuels moyens par utilisateur (environ 1.5 dollars/an) de Skype!

Source: blog Media & Tech (par didier durand)

mardi, août 29, 2006

Netvibes, YouTube, etc...: comment trancher le noeud gordien communautaire pour les startups du web 2.0?

2 billets (très courts) me font pas mal réfléchir ces jours-ci sur la manière de gérer (financièrement) de manière correcte une société du web 2.0 sans "passer la ligne jaune" dans la composante communautaire (la fameuse "intelligence collective" ou "sagesse des foules" - voir aussi Wikipedia ci-dessous en fin de billet) d'un tel service:

Cette communauté est souvent le contributeur très majoritaire (par rapport à la start-up elle-même) pour la création (vidéos chargées sur YouTube par ex.) et l'organisation (tagging, ranking, commentaires, etc...) du contenu qui rassemble tout ce petit monde.

Or, les startups ont des frais à couvrir (voir YouTube et ses frais de réseau) : elles font donc appel à l'argent des venture capitalists. Ceux-ci ne sont pas des mécènes philanthropes: ils veulent - au plus vite - un retour sur investissement à multiple fort.

C'est là que la situation inextricable naît: la communauté sélectionne et fait émerger des contenus d'auteurs / producteurs qui sont différents de ceux qui sont prêts à payer beaucoup.

A partir de là, comment fait-on ?

Il y en a un qui a clairement tranché le sujet: c'est Craig Newmark, le fondateur de Craigslist. Dans cet interview de JM. Billaut, il réaffirme que c'est pour ne pas avoir à se trouver en porte-à-faux par rapport à sa communauté qu'il a toujours refusé les dollars du capital-risque (.... et qu'il est finalement nettement moins riche qu'il aurait pu l'être sachant qu'il subtilise plus de 500 millions de dollars chaque année aux éditeurs!).

Les bons modèles d'affaires du web 2.0 selon vous, c'est quoi? Moi, je sèche un peu...

Merci de vos idées et commentaires sur le sujet: comme pour le géoportail, je ferai un billet de vos réflexions (si la matière est suffisante).

Rappel de la définition du Web 2.0 Wikipedia:

" ...

Les partisans de l'approche Web 2.0 pensent que l'utilisation du Web s'oriente de plus en plus vers l'interaction entre les utilisateurs, et la création de réseaux sociaux rudimentaires, pouvant servir du contenu exploitant les effets de réseau, avec ou sans réel rendu visuel et interactif de pages Web. En ce sens, les sites Web 2.0 agissent plus comme des points de présence, ou portails web centrés sur l'utilisateur plutôt que sur les sites web traditionnels.

...

il est généralement admis qu'un site Web 2.0 doit montrer certaines caractéristiques :

Source: blog Media & Tech (par didier durand)

- Le premier sur JasonBlogs à propos de l'introduction des placements publicitaires sur YouTube: "Now that YouTube accepts payment for promoting videos to the homepage and creating custom channels and profiles, can they be trusted? How long will it be until they decide to accept payment for top placement in search results? And once that happens is the site no longer run by the community?"

- Le second sur le blog d'Henri Labarre: "Citation de Tarik Krim, issue de l’article de International Herald Tribune sur Netvibes. “I am not worried about revenue right now, I am concerned about the user experience,” Krim said. “Once users are happy, I am sure the revenue model will make itself clear.” Je ne sais pas si les ventures capitalists sont rassurés maintenant!

Cette communauté est souvent le contributeur très majoritaire (par rapport à la start-up elle-même) pour la création (vidéos chargées sur YouTube par ex.) et l'organisation (tagging, ranking, commentaires, etc...) du contenu qui rassemble tout ce petit monde.

Or, les startups ont des frais à couvrir (voir YouTube et ses frais de réseau) : elles font donc appel à l'argent des venture capitalists. Ceux-ci ne sont pas des mécènes philanthropes: ils veulent - au plus vite - un retour sur investissement à multiple fort.

C'est là que la situation inextricable naît: la communauté sélectionne et fait émerger des contenus d'auteurs / producteurs qui sont différents de ceux qui sont prêts à payer beaucoup.

A partir de là, comment fait-on ?

- on donne la priorité au contenu commercial et la communauté fuit car elle n'est plus écoutée et se sent même bafouée...

- on garde la communauté en tête de liste mais on ne reçoit plus l'argent publicitaire?

Il y en a un qui a clairement tranché le sujet: c'est Craig Newmark, le fondateur de Craigslist. Dans cet interview de JM. Billaut, il réaffirme que c'est pour ne pas avoir à se trouver en porte-à-faux par rapport à sa communauté qu'il a toujours refusé les dollars du capital-risque (.... et qu'il est finalement nettement moins riche qu'il aurait pu l'être sachant qu'il subtilise plus de 500 millions de dollars chaque année aux éditeurs!).

Les bons modèles d'affaires du web 2.0 selon vous, c'est quoi? Moi, je sèche un peu...

Merci de vos idées et commentaires sur le sujet: comme pour le géoportail, je ferai un billet de vos réflexions (si la matière est suffisante).

Rappel de la définition du Web 2.0 Wikipedia:

" ...

Les partisans de l'approche Web 2.0 pensent que l'utilisation du Web s'oriente de plus en plus vers l'interaction entre les utilisateurs, et la création de réseaux sociaux rudimentaires, pouvant servir du contenu exploitant les effets de réseau, avec ou sans réel rendu visuel et interactif de pages Web. En ce sens, les sites Web 2.0 agissent plus comme des points de présence, ou portails web centrés sur l'utilisateur plutôt que sur les sites web traditionnels.

...

il est généralement admis qu'un site Web 2.0 doit montrer certaines caractéristiques :

- Le site ne doit pas être un jardin secret, c'est à dire qu'il doit être aisé de faire rentrer ou sortir des informations du système ;

- L'utilisateur doit rester propriétaire de ses propres données ;

- Le site doit être entièrement utilisable à travers un navigateur standard ;

- Des aspects de réseaux sociaux.

Utilisation des étiquettes, plus d'un système de pondération généralement défini par un facteur humain (le côté social) pour mettre en valeur les articles intéressants dans des systèmes d'informations, typiquement des répertoires de blogs. (Social Bookmarking en anglais).

L'étiquettage permet un tri préalable des articles recherchés et soit le nombre de références, soit un note donnée par les lecteurs crée l'ordre d'apparition des articles.

...."

Source: blog Media & Tech (par didier durand)

lundi, août 28, 2006

Après MySpace, Google signe avec EBay/Skype pour le click-to-call - Google 2 - 0 Yahoo!

Après le deal MySpace, Google frappe un nouveau grand coup! Cette fois, c'est un deal pluri-annuel avec EBay/Skype. Il est basé sur le partage des revenus sans que les sociétés en divulguent les termes précis.

Il contient 2 versants:

Pour moi, le click-to-call est important car il est le chaînon manquant entre la publicité en ligne et les petits annonceurs locaux. Ceux-ci n'ont pas les moyens d'utiliser pleinement la publicité pay-per-click par manque de compétences / infrastructure / contenu sur Internet. le clic-to-call va leur permettre d'annoncer efficacement en ligne (un média maintenant incontournable - au moins aux USA...) en routant les prospects Internet vers un canal que les petits commerces utilisent parfaitement: le téléphone!

Google avait dit récemment "laisser de l'argent sur la table" à propos du marché de la publicité locale estimé à 22 milliards de dollars aux USA. Eh bien, dès aujourd'hui, il en traîne déjà tout de suite beaucoup moins! Et la croissance de vitesse de la publicité en ligne va pouvoir augmenter pour être conforme aux besoins de Google en la matière....

Source: blog Media & Tech (par didier durand)

Il contient 2 versants:

- le boost des publicités "click-to-call": Google les avait lancées il y a plusieurs mois en tests expérimentaux. Maintenant, c'est le coup d'accélérateur: elles vont devenir une option standard dans Google Adwords/AdSense et sur Ebay. Bien sûr quand on compare le maigre résultat de Google Talk et la communauté florissante Skype (100+ millions d'utilisateurs enregistrés), on voit pourquoi Google collabore avec Skype comme canal de communication pour la partie "call" de ce nouveau mode publicitaire!

- Google fournira toutes les publicités textuelles sur les sites non-américains de EBay.

Pour moi, le click-to-call est important car il est le chaînon manquant entre la publicité en ligne et les petits annonceurs locaux. Ceux-ci n'ont pas les moyens d'utiliser pleinement la publicité pay-per-click par manque de compétences / infrastructure / contenu sur Internet. le clic-to-call va leur permettre d'annoncer efficacement en ligne (un média maintenant incontournable - au moins aux USA...) en routant les prospects Internet vers un canal que les petits commerces utilisent parfaitement: le téléphone!

Google avait dit récemment "laisser de l'argent sur la table" à propos du marché de la publicité locale estimé à 22 milliards de dollars aux USA. Eh bien, dès aujourd'hui, il en traîne déjà tout de suite beaucoup moins! Et la croissance de vitesse de la publicité en ligne va pouvoir augmenter pour être conforme aux besoins de Google en la matière....

Source: blog Media & Tech (par didier durand)

EC2 après S3: le "nuage informatique élastique" d'Amazon pour le web 2.0 = virtualisation des CPUs

Quand Amazon a lancé son Service de Stockage Simple (S3 - "Simple Storage Service"), j'avais écrit qu'il livait une pièce importante du puzzle de construction des nouvelles entreprises du web 2.0:

"Ce sont des services aussi simples (et c'est volontaire, dixit Amazon) que ceux-ci qui sont nécessaires à bâtir une nouvelle génération d'entreprises sans infrastructure propres donc très agiles à une époque où la rapidité de mutation devient vitale!"

Eh bien, aujourd'hui avec EC2 ("Elastic Computing Cloud"), Amazon complète la panoplie de la startup du web 2.0 agile et flexible qui évolue vite en offrant la location à l'heure de machines Linux virtualisées: après le stockage, la capacité de calcul à la demande est maintenant là!

Cette image virtuelle est "exécutée" par Amazon et facturée 10 cents à l'heure par instance: plusieurs instances simultanées d'une même image Linux sont bien sûr possibles pour des tests ou une architecture à croissance horizontale. (le trafic est en sus selon les tarifs S3).

En calculant qu'un mois revient à 72 dollars, Michael Arrington de Techcrunch trouve le prix encore élevé: le prix de location d'une machine équivalente dédiée dans un centre d'hébergement aux USA est de 50 dollars environ.

C'est peut-être vrai aujourd'hui, mais ce prix va baisser! Google a 450'000 serveurs et Microsoft en prépare 800'000: ils pourraient donc tout comme Amazon et pour entrer en concurrence avec lui sur ce nouveau marché en donner accès à des clients payants pour les faire bénéficier de leur excellence opérationnelle (à moins qu'ils ne considèrent que ce serait brader un de leurs avantages stratégiques - Jean-Michel Salaun voit ces monstrueux centres de calcul comme tels)

Pour moi, le point le plus intéressant est que l'on peut maintenant bâtir une société du web 2.0 sans posséder aucune infrastructure ni obliger un hébergeur à dédier une (ou plusieurs) machine(s) pour soi. Cette virtualisation se fait de plus en conservant malgré tout une totale autonomie de configuration (à la différence des hébergements partagés actuels standars Apache+PHP/Perl+MySQL)

La virtualisation de l'informatique et son mode d'utilisation /facturation à la demande sont maintenant vraiment en marche! (juste encore quelques mois de rodage...)

J'avais écrit en Avril 2004 dans un article pour le quotidien Agefi sur la synergie entre Logiciel Libre (OSS) et On-Demand Computing:

"Vers une flexibilisation parfaite des coûts: l’ère du «On-demand Computing» véritable débutera quand l’énergie informationnelle issue des traitements par ordinateurs pourra être obtenue à partir de centrales informatiques distantes: des groupes d’ordinateurs banalisés y traiteront simultanément et de manière intégrée l’ensemble des programmes (écrits sur des bases technologiques identiques) et des données d’une foule de clients.

Ces derniers ne seront alors facturés qu’en fonction de ce qu'ils auront réellement consommé, et non pas des «boîtes» qu’ils hébergent le plus souvent à coûts fixes dans leurs centres de calcul internes! Cette nouvelle forme permettra une parfaite flexibilisation des coûts par rapport aux besoins et évolutions des affaires de la société .

Les entreprises utilisatrices doivent cependant encore faire leur part du travail: el les doivent harmoniser entre el les (de manière inconsciente…) les plateformes informatiques qu’elles utilisent.

Mais, la vision théorique, et peut-être quelque peu utopique, évoquée plus haut n’est pas nécessaire ment le but initial des sociétés qui mettent en place en leur sein l’OSS et ses proches cousins comme Java. En effet, les économies financières directes massives d’acquisition puis d’évolution réalisables via l’OSS représentent sou vent un but premier plus séduisant. Il pave de toute façon la voie vers la seconde étape!"

Eh bien, 28 mois plus tard, une telle centrale d'énergie informatique ouverte existe: chez Amazon! Je pensais à l'époque que cela mettrait plus de temps...

Par contre, l'autre face de l'équation me semble effectivement plus lente: la migration par les grandes entreprises de leur informatique commerciale vers le Logiciel Libre n'est pas encore vraiment entamée ou trop frileuse dans la majeure partie des cas!

Bon, pour avoir mené un tel projet chez mon employeur pendant 3 ans à partir d'un mainframe IBM migré vers Linux (projet NACA), je sais que c'est un immense chantier mais les bénéfices résultants sont énormes!

EC2 - caractéristiques techniques (pour les fans...):

L'ensemble des spécifications ci-après sont données par un billet sur un blog officiel d'Amazon.

La virtualisation du service de location est complète: Amazon n'impose rien au niveau de la configuration de Linux.

C'est le client qui définit totalement les paramètres de son image Linux (appelée AMI = Amazon Machine Image - basée sur la distribution Redhat Fedora) qu'il télécharge ensuite sur l'infrastructure Amazon.

Quand elle est activée, l'image Linux tourne ensuite sur un serveur virtuel équivalent à un Xeon 1.7Ghz avec 1.75GB de RAM et 160 GB de disque local avec 250Mb/s de débit réseau.

Le logiciel de virtualisation est Xen, le clone Open Source du célèbre VmWare. Cette version libre monte actuellement fortement en puissance!

Source: blog Media & Tech (par didier durand)

"Ce sont des services aussi simples (et c'est volontaire, dixit Amazon) que ceux-ci qui sont nécessaires à bâtir une nouvelle génération d'entreprises sans infrastructure propres donc très agiles à une époque où la rapidité de mutation devient vitale!"

Eh bien, aujourd'hui avec EC2 ("Elastic Computing Cloud"), Amazon complète la panoplie de la startup du web 2.0 agile et flexible qui évolue vite en offrant la location à l'heure de machines Linux virtualisées: après le stockage, la capacité de calcul à la demande est maintenant là!

Cette image virtuelle est "exécutée" par Amazon et facturée 10 cents à l'heure par instance: plusieurs instances simultanées d'une même image Linux sont bien sûr possibles pour des tests ou une architecture à croissance horizontale. (le trafic est en sus selon les tarifs S3).

En calculant qu'un mois revient à 72 dollars, Michael Arrington de Techcrunch trouve le prix encore élevé: le prix de location d'une machine équivalente dédiée dans un centre d'hébergement aux USA est de 50 dollars environ.

C'est peut-être vrai aujourd'hui, mais ce prix va baisser! Google a 450'000 serveurs et Microsoft en prépare 800'000: ils pourraient donc tout comme Amazon et pour entrer en concurrence avec lui sur ce nouveau marché en donner accès à des clients payants pour les faire bénéficier de leur excellence opérationnelle (à moins qu'ils ne considèrent que ce serait brader un de leurs avantages stratégiques - Jean-Michel Salaun voit ces monstrueux centres de calcul comme tels)

Pour moi, le point le plus intéressant est que l'on peut maintenant bâtir une société du web 2.0 sans posséder aucune infrastructure ni obliger un hébergeur à dédier une (ou plusieurs) machine(s) pour soi. Cette virtualisation se fait de plus en conservant malgré tout une totale autonomie de configuration (à la différence des hébergements partagés actuels standars Apache+PHP/Perl+MySQL)

La virtualisation de l'informatique et son mode d'utilisation /facturation à la demande sont maintenant vraiment en marche! (juste encore quelques mois de rodage...)

J'avais écrit en Avril 2004 dans un article pour le quotidien Agefi sur la synergie entre Logiciel Libre (OSS) et On-Demand Computing:

"Vers une flexibilisation parfaite des coûts: l’ère du «On-demand Computing» véritable débutera quand l’énergie informationnelle issue des traitements par ordinateurs pourra être obtenue à partir de centrales informatiques distantes: des groupes d’ordinateurs banalisés y traiteront simultanément et de manière intégrée l’ensemble des programmes (écrits sur des bases technologiques identiques) et des données d’une foule de clients.

Ces derniers ne seront alors facturés qu’en fonction de ce qu'ils auront réellement consommé, et non pas des «boîtes» qu’ils hébergent le plus souvent à coûts fixes dans leurs centres de calcul internes! Cette nouvelle forme permettra une parfaite flexibilisation des coûts par rapport aux besoins et évolutions des affaires de la société .

Les entreprises utilisatrices doivent cependant encore faire leur part du travail: el les doivent harmoniser entre el les (de manière inconsciente…) les plateformes informatiques qu’elles utilisent.

Mais, la vision théorique, et peut-être quelque peu utopique, évoquée plus haut n’est pas nécessaire ment le but initial des sociétés qui mettent en place en leur sein l’OSS et ses proches cousins comme Java. En effet, les économies financières directes massives d’acquisition puis d’évolution réalisables via l’OSS représentent sou vent un but premier plus séduisant. Il pave de toute façon la voie vers la seconde étape!"

Eh bien, 28 mois plus tard, une telle centrale d'énergie informatique ouverte existe: chez Amazon! Je pensais à l'époque que cela mettrait plus de temps...

Par contre, l'autre face de l'équation me semble effectivement plus lente: la migration par les grandes entreprises de leur informatique commerciale vers le Logiciel Libre n'est pas encore vraiment entamée ou trop frileuse dans la majeure partie des cas!

Bon, pour avoir mené un tel projet chez mon employeur pendant 3 ans à partir d'un mainframe IBM migré vers Linux (projet NACA), je sais que c'est un immense chantier mais les bénéfices résultants sont énormes!

EC2 - caractéristiques techniques (pour les fans...):

L'ensemble des spécifications ci-après sont données par un billet sur un blog officiel d'Amazon.

La virtualisation du service de location est complète: Amazon n'impose rien au niveau de la configuration de Linux.

C'est le client qui définit totalement les paramètres de son image Linux (appelée AMI = Amazon Machine Image - basée sur la distribution Redhat Fedora) qu'il télécharge ensuite sur l'infrastructure Amazon.

Quand elle est activée, l'image Linux tourne ensuite sur un serveur virtuel équivalent à un Xeon 1.7Ghz avec 1.75GB de RAM et 160 GB de disque local avec 250Mb/s de débit réseau.

Le logiciel de virtualisation est Xen, le clone Open Source du célèbre VmWare. Cette version libre monte actuellement fortement en puissance!

Source: blog Media & Tech (par didier durand)

samedi, août 26, 2006

Google trop riche: la régulation des fonds de placement pourrait s'activer - Le temps des acquisitions?

Bloomberg rapporte que la part du cash (ou équivalent) dans les actifs de Google est très élevée (9.4 milliards de dollars au 30 Juin - >40% des actifs circulants) . Pour obtenir les meilleurs performances boursières, Google veut investir ses liquidités dans des instruments financiers à plus haut rendement que les obligations émises par la banque fédérale US (et similaires)

Il a donc demandé une exemption à la SEC (le gendarme de la Bourse américaine) le mois dernier pour ne pas tomber alors sous la régulation (très stricte) des fonds de placement.

Selon Bloomberg, Microsoft avait obtenu une telle exemption en 1998 et Yahoo une en 2000. Microsoft avait ainsi pu doubler la rentabilité de ses liquidités.

Mais, le but d'une société comme Google n'est pas de devenir un investisseur dans des instruments financiers (même si sa croissance est explosive): il devrait rendre cet argent aux actionnaires si il ne sait pas quoi en faire car c'est la logique fondamentale de l'actionnariat.

Donc, comme le dit John Batelle, pour éviter cette restitution, le temps des acquisitions (majeures) est sûrement proche....

Source: blog Media & Tech (par didier durand)

Il a donc demandé une exemption à la SEC (le gendarme de la Bourse américaine) le mois dernier pour ne pas tomber alors sous la régulation (très stricte) des fonds de placement.

Selon Bloomberg, Microsoft avait obtenu une telle exemption en 1998 et Yahoo une en 2000. Microsoft avait ainsi pu doubler la rentabilité de ses liquidités.

Mais, le but d'une société comme Google n'est pas de devenir un investisseur dans des instruments financiers (même si sa croissance est explosive): il devrait rendre cet argent aux actionnaires si il ne sait pas quoi en faire car c'est la logique fondamentale de l'actionnariat.

Donc, comme le dit John Batelle, pour éviter cette restitution, le temps des acquisitions (majeures) est sûrement proche....

Source: blog Media & Tech (par didier durand)

vendredi, août 25, 2006

Accès Internet: marché mondial =140 milliards de dollars en 2006 dont 81.2 milliards pour le haut débit

La Telecommunications Industry Association (TIA) annonce, dans sa nouvelle étude, que les revenus mondiaux pour les fournisseurs d'accès à Internet (FAI) se sont élevés à 113.3 milliards de dollars en 2005. Ils sont projetés à 140 pour 2006 puis 221 pour 2009. Croissance annuelle moyenne: +18.3%

C'est bien sûr le haut débit qui assure une grande partie de cette croissance: d'autres chiffres Yahoo ont montré que la croissance de la population internaute mondiale passait essentiellement par de nouveaux accès à haut débit. la TIA dit que la croissance annuelle moyenne du haut débit pour ces prochaines années sera de +28.3%: de 57.6 milliards de dollars en 2005 à 81.2 milliards en 2006 puis 156.1 milliards en 2009.

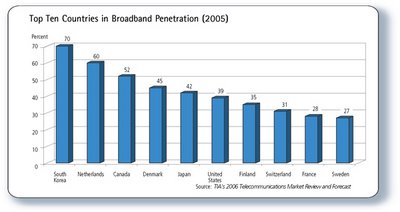

En terme de pénétration dans les foyers (2005):

[cliquez sur l'image pour l'agrandir]

"l'aspect le plus important du haut débit (adsl ou câble) est finalement le mode toujours connecté ("always on") qui fait que la fréquence d'utilisation devient énorme: beaucoup de petites choses successives dans la journée dès qu'il y a un besoin d'information.

Le côté haut débit a eu finalement moins d'impact à la maison jusqu'à présent: juste une vidéo (souvent issue de Youtube.com comme celle Ronaldhino par ex) de temps en temps mais rien de réellment addictif! (à ce jour)"

En quelques mois, le côté addictif de la vidéo grâce au haut-débit s'est finalement manifesté dans notre famille!

Et chez vous?

Source: blog Media & Tech (par didier durand)

C'est bien sûr le haut débit qui assure une grande partie de cette croissance: d'autres chiffres Yahoo ont montré que la croissance de la population internaute mondiale passait essentiellement par de nouveaux accès à haut débit. la TIA dit que la croissance annuelle moyenne du haut débit pour ces prochaines années sera de +28.3%: de 57.6 milliards de dollars en 2005 à 81.2 milliards en 2006 puis 156.1 milliards en 2009.

En terme de pénétration dans les foyers (2005):

[cliquez sur l'image pour l'agrandir]

- la Corée du Sud reste leader avec 70% des ménages connectés en haut débit

- les Etats-Unis sont 6ème avec 39% même si JM Billaut s'est récemment abondamment plaint du peu de débit réel de ces accès aux USA lors de son périple en Californie.

- la Suisse (mon pays professionnel) est 8ème avec 31%

- la France est 9ème avec 28%.

"l'aspect le plus important du haut débit (adsl ou câble) est finalement le mode toujours connecté ("always on") qui fait que la fréquence d'utilisation devient énorme: beaucoup de petites choses successives dans la journée dès qu'il y a un besoin d'information.

Le côté haut débit a eu finalement moins d'impact à la maison jusqu'à présent: juste une vidéo (souvent issue de Youtube.com comme celle Ronaldhino par ex) de temps en temps mais rien de réellment addictif! (à ce jour)"

En quelques mois, le côté addictif de la vidéo grâce au haut-débit s'est finalement manifesté dans notre famille!

Et chez vous?

Source: blog Media & Tech (par didier durand)

jeudi, août 24, 2006

Après le deal publicitaire Google-MySpace, maintenant Microsoft-Facebook

MySpace et FaceBook (bonne présentation du site par InternetActu) sont certainement les icônes (en tout cas sur le marché américain) des sites de "social networking" du web 2.0 où l'UGC ("User Generated Content") est roi.

Emanuel a longuement décrit début Août le deal de 900 millions de dollars garantis sur 3 ans entre Google et Fox Interactive de Ruppert Murdoch (la société-mère de MySpace depuis son rachat). Ces 900 millions de régie publicitaire exclusive par Google couvrent largement le prix d'acquisition et sûrement les frais d'exploitation (inconnus) de MySpace.

Aujourd'hui, c'est un accord similaire entre Microsoft et l'autre star du web 2.0 qui émerge: Facebook a choisi Microsoft comme régie publicitaire pour son site "entretenu et enrichi" par ses 9 millions d'utilisateurs-étudiants. Les termes financiers de cet accord ne sont pas divulgués cependant il a été rendu public que les publicités seront à la fois pay-per-click et bannières dès le début. Un des objectifs de FaceBook est sûrement de remonter sa part de marché actuelle (7.51% du web social contre 80% à MySpace selon Hitwise) en obtenant des liens vers lui depuis les sites MSN de Microsoft.

La course entre les géants du web est donc ouverte entre les géants pour combler les trous qu'ils ont laissé dans l'espace du web 2.0 (web social): ils commencent par devenir régies publicitaires des leaders de ce nouveau "terrain de jeu" mais ils ont sûrement plus en tête....

PS: MySpace France a bien démarré en France (on en avait parlé) durant l'été pour concurrencer le WAT de TF1: voir fr.myspace.com - on devrait donc y voir les boîtes publicitaires "pay-per-click" de Google très bientôt!

Source: blog Media & Tech (par didier durand)

Emanuel a longuement décrit début Août le deal de 900 millions de dollars garantis sur 3 ans entre Google et Fox Interactive de Ruppert Murdoch (la société-mère de MySpace depuis son rachat). Ces 900 millions de régie publicitaire exclusive par Google couvrent largement le prix d'acquisition et sûrement les frais d'exploitation (inconnus) de MySpace.

Aujourd'hui, c'est un accord similaire entre Microsoft et l'autre star du web 2.0 qui émerge: Facebook a choisi Microsoft comme régie publicitaire pour son site "entretenu et enrichi" par ses 9 millions d'utilisateurs-étudiants. Les termes financiers de cet accord ne sont pas divulgués cependant il a été rendu public que les publicités seront à la fois pay-per-click et bannières dès le début. Un des objectifs de FaceBook est sûrement de remonter sa part de marché actuelle (7.51% du web social contre 80% à MySpace selon Hitwise) en obtenant des liens vers lui depuis les sites MSN de Microsoft.

La course entre les géants du web est donc ouverte entre les géants pour combler les trous qu'ils ont laissé dans l'espace du web 2.0 (web social): ils commencent par devenir régies publicitaires des leaders de ce nouveau "terrain de jeu" mais ils ont sûrement plus en tête....

PS: MySpace France a bien démarré en France (on en avait parlé) durant l'été pour concurrencer le WAT de TF1: voir fr.myspace.com - on devrait donc y voir les boîtes publicitaires "pay-per-click" de Google très bientôt!

Source: blog Media & Tech (par didier durand)

mardi, août 22, 2006

Google Checkout avec les jeans Levi Strauss: pas dans la poche!

Alors qu'il était mis en avant comme partenaire prestigieux (parmi une centaine) par Google lors du lancement, le site des jeans Levi Strauss a déjà stoppé le paiement via Google Checkout.

Selon un article MarketWatch, c'est à cause d'un "problème particulier" ("particular issue") rencontré par Levi Strauss. Comme le dit une représentante de Ebay/Paypal dans ce même article: "un service de paiment en ligne, c'est très complexe"...

MarketWatch dit aussi que beaucoup de plaintes d'utilisateurs font surface par rapport à la lenteur de ce service Google Checkout.

Finalement, la sanction d'Ebay par rapport à Google Checkout n'est peut-être pas une peau de banane concurrentielle mais seulement le fruit d'un constat opérationel: Ebay avait dit très tôt que Checkout ne remplissait pas certains critères lui permettant de faire partie de sa plate-forme.

Pas simple de se diversifier dans de multiples directions pour maintenir une croissance explosive qui reste impérative pour les investisseurs...

[via P. Lenssen]

Source: blog Media & Tech (par didier durand)

Selon un article MarketWatch, c'est à cause d'un "problème particulier" ("particular issue") rencontré par Levi Strauss. Comme le dit une représentante de Ebay/Paypal dans ce même article: "un service de paiment en ligne, c'est très complexe"...

MarketWatch dit aussi que beaucoup de plaintes d'utilisateurs font surface par rapport à la lenteur de ce service Google Checkout.

Finalement, la sanction d'Ebay par rapport à Google Checkout n'est peut-être pas une peau de banane concurrentielle mais seulement le fruit d'un constat opérationel: Ebay avait dit très tôt que Checkout ne remplissait pas certains critères lui permettant de faire partie de sa plate-forme.

Pas simple de se diversifier dans de multiples directions pour maintenir une croissance explosive qui reste impérative pour les investisseurs...

[via P. Lenssen]

Source: blog Media & Tech (par didier durand)

Etat de la blogosphere en Août 2006: croissance toujours exponentielle!

Comme tous les 3 mois (environ), Dave Sifry, ceo de Technorati, nous fournit un état de la blogosphère:

Source: blog Media & Tech (par didier durand)

- Technorati visite et indexe plus de 50 millions de blogs depuis le 31 Juillet

- la blogosphère est 100 fois plus grosse qu'il y a 3 ans

- elle double de taille tous les 200 jours

- 175'00 nouveaux blogs tous les jours: 2 "naissances" par seconde

- 75% des pings reçus sont du spam (qui n'est même pas exploré par Technorati)

- 1.6 millions de billets par jour: soit plus de 18 par seconde (2 fois plus qu'il y a 1 an: donc le nombre d'auteurs augmente plus vite que leur production...)

Source: blog Media & Tech (par didier durand)

dimanche, août 20, 2006

Google: 1 million $ pour le Wifi à Mountain View - Pas de plans nationaux

Le blog de Google confirme le lancement officiel du service wifi (gratuit) dans toute sa ville berceau de Mountain View. C'est l'épilogue d'un projet accepté en Novembre 2005 par la municipalité de Moutain View.

Le NYT publie également un article pour boucler ce sujet avec des informations intéressantes données par Chris Sacca qui pilote les projets spéciaux chez Google:

Il suggère donc que des services déjà évoqués vont gagner en puissance avec le démarrage de ce service wifi public. On peut penser:

Source: blog Media & Tech (par didier durand)

Le NYT publie également un article pour boucler ce sujet avec des informations intéressantes données par Chris Sacca qui pilote les projets spéciaux chez Google:

- les négociations avec la ville de San Francisco pour un projet similaire se poursuivent: les 2 opérateurs déjà officiellement choisis (Google et EarthLink) définissent les termes du contrat de service avec la municipalité

- Google a installé 380 antennes Wifi pour équiper sa ville natale de 72'000 habitants. La carte détaillée des points d'accès est publiée via Google Maps (bien sûr!). Le coût de cette infrastructure est de 1 million de dollars. Google a également beaucoup dépensé en mini-stages de formation pour éduquer les habitants au wifi.

- Le service offert est de 1 mégabit/seconde symétrique au début mais Google a déjà fait des essais à 8 mégabits/seconde. Cela sera activé après quelques mois de retour d'expérience à 1 Mbps.

- Google n'a pas d'objectifs nationaux après Mountain View et San Francisco: il s'agit seulement d'avoir 2 terrains d'expérimentation (laboratoires "en live") pour de nouveaux services.

- Il s'agit aussi de montrer jusqu'où les utilisateurs pourront aller dans l'utilisation de l'Internet si la barrière du monopole actuel des telcos américains est levée. En particulier, il s'agit de tuer le débat de la "Net Neutrality" (l'Atelier le résume bien ici) qui bouillonne aux USA depuis le début de l'année en montrant qu'une utilisation très libre pour fournisseurs de contenus / services et internautes est bien plus profitable à la société qu'une taxation (maximum) à plusieurs vitesses du trafic sur le réseau.

Il suggère donc que des services déjà évoqués vont gagner en puissance avec le démarrage de ce service wifi public. On peut penser:

- aux publicités cartographiques très locales décrites dans ce billet

- aux offres spéciales que j'évoquais dans ce billet: "vous êtes sur le point d'accès Wifi proche de notre terrasse, 20% de réduction si vous venez chez nous maintenant muni de ce coupon électronique pour boire un bon cappuccino en terminant vos emails!".A ce titre , le démarrage actuel du service de coupons sur Google Maps aux USA (communiqué officiel ici) n'est sûrement pas anodin!

Source: blog Media & Tech (par didier durand)

samedi, août 19, 2006

utilisation du verbe "to google": les avocats de Google sont contre!

Quand le verbe "to google" était entré dans le dictionnaire anglais Oxford officiel, j'avais évoqué la fierté qu'une société aussi jeune que Google peut avoir à rejoindre les Guillotin et autres Poubelle (... ou leurs équivalents anglophones comme Kleenex!).

Eh bien, que nenni! Les avocats de Google ont écrit à un certain nombre de grands médias pour les avertir des utilisations inappropriées du verbe "to google".

Le Washington Post nous dit que la lettre reçue par sa rédaction lui explique que:

Sachant que la devise officielle est "don't be evil" ("ne pas pas faire le mal") et même si la loi des marques impose une défense permanente pour en garder la propriété, je trouve messieurs les juristes "googliens" (euh pardon, ..."du moteur de recherche Google") que vous en faites trop!

PS: le blog des correcteurs du site internet de Le Monde avait pointé mon billet pour évoquer l'apparition de ce verbe. Peut-être vont-ils maintenant nous dire si ils ont reçu ce même genre de courrier de la part de Google France?

[via Andreas]

Source: blog Media & Tech (par didier durand)

Eh bien, que nenni! Les avocats de Google ont écrit à un certain nombre de grands médias pour les avertir des utilisations inappropriées du verbe "to google".

Le Washington Post nous dit que la lettre reçue par sa rédaction lui explique que:

- On ne dit pas "je me suis googlé" mais plutôt "j'ai fait une égo-recherche sur le moteur Google comment j'y apparaît"

- On ne dit pas "j'ai googlé cette meuf super cool de la soirée d'hier" mais plutôt "j'ai effectué une recherche sur le moteur Google afin de trouver des informations sur cette jeune femme présente à la soirée d'hier"

Sachant que la devise officielle est "don't be evil" ("ne pas pas faire le mal") et même si la loi des marques impose une défense permanente pour en garder la propriété, je trouve messieurs les juristes "googliens" (euh pardon, ..."du moteur de recherche Google") que vous en faites trop!

PS: le blog des correcteurs du site internet de Le Monde avait pointé mon billet pour évoquer l'apparition de ce verbe. Peut-être vont-ils maintenant nous dire si ils ont reçu ce même genre de courrier de la part de Google France?

[via Andreas]

Source: blog Media & Tech (par didier durand)

Youtube rentable avant fin 2006 ?

C'est que disent ces 2 fondateurs, Steve Chen et Chad Hurley (2 ex- de Paypal) dans leur interview analysée par E. Parody sur Ecosphere:

"Coup de bluff ou non ils affirment être bientôt rentables avant la fin de l’année 2006 avec des revenus 100% en provenance de la pub. C’est peut être un effet de leur jeunesse mais j’ai trouvé que ce passage manquait de conviction. Le genre de réponse où il faut analyser chaque mot. Principal risque avoué : le copyright, d’autant que la publicité devrait faire son apparition même on ne sait pas encore vraiment sous quelle forme."

Le trafic continue à exploser: avec plus de 100 millions de vidéos vues chaque jour, ce n'est pas la question.

Le vrai problème: c'est que la vidéo (même très bien compressée....) consomme beaucoup de bande passante très coûteuse. La pub suffira-t-elle à elle seule ou faudra-t-il à un moment commencer à appuyer sur le frein afin de ne pas devenir la 1ère grosse gamelle du web 2.0?

A suivre ces prochains mois...

Source: blog Media & Tech (par didier durand)

"Coup de bluff ou non ils affirment être bientôt rentables avant la fin de l’année 2006 avec des revenus 100% en provenance de la pub. C’est peut être un effet de leur jeunesse mais j’ai trouvé que ce passage manquait de conviction. Le genre de réponse où il faut analyser chaque mot. Principal risque avoué : le copyright, d’autant que la publicité devrait faire son apparition même on ne sait pas encore vraiment sous quelle forme."

Le trafic continue à exploser: avec plus de 100 millions de vidéos vues chaque jour, ce n'est pas la question.

Le vrai problème: c'est que la vidéo (même très bien compressée....) consomme beaucoup de bande passante très coûteuse. La pub suffira-t-elle à elle seule ou faudra-t-il à un moment commencer à appuyer sur le frein afin de ne pas devenir la 1ère grosse gamelle du web 2.0?

A suivre ces prochains mois...

Source: blog Media & Tech (par didier durand)

mardi, août 01, 2006

Fraude aux clics: Google devient plus transparent

Les publications sur la fraude aux clics (dans Google AdSense en particulier) montrait un taux inquiétant d'environ 15%. En plus, les propos du ceo de Google sur le sujet étaient déformés par la presse.

Il fallait donc réagir:

Donc, sous la pression médiatique, Google a fait rapidement 2 grands pas en avant dans le domaine de la lutte contre la fraude aux clics. Tant mieux: ce sera sûrement salutaire pour toute la branche!

Et puis, tout s'arrange finalement: l'arrangement à l'amiable proposé par Google dans le procès Lane Gift (rappelez-vous "la fraude est immatérielle"...) a été accepté par le juge selon le blog Google (InternetNews en parle aussi)

Bien sûr, il manque toujours les chiffres globaux de Google sur la fraude aux clics. Mais, après ces avancées, je suis maintenant plus optimiste sur leur prochaine publication que par le passé: j'oserais presque parier pour une première publication encore cette année...

Source: blog Media & Tech (par didier durand)

Il fallait donc réagir:

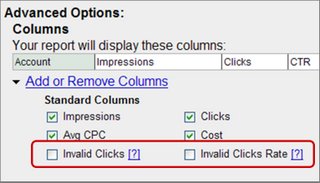

- Google a fait analyser ses mesures anti-fraudes dans AdSense par un expert indépendant ( Dr. Alexander Tuzhilin de l'université de New-York) qui a remis son rapport. Le blog de Google publie un lien vers ce rapport. Ce document analyse la batterie de mesures prises pour conclure qu'elles paraissent "raisonnables" (= "conformes à l'état de l'art actuel"). Il ne donne par contre aucun chiffre sur les taux de fraude globaux que ces mesures détectent.

- Par ailleurs, sur son blog, Philipp Lenssen a publié la capture d'écran ci-dessous qui prouve que Google commence maintenant à publier les taux et nombres de clics frauduleux détectés (et bien sûr non facturés!) sur certains comptes AdWords: Mais, pas encore tous: par exemple, ceux auxquels j'ai accès ne reçoivent pas encore cette information.

Donc, sous la pression médiatique, Google a fait rapidement 2 grands pas en avant dans le domaine de la lutte contre la fraude aux clics. Tant mieux: ce sera sûrement salutaire pour toute la branche!

Et puis, tout s'arrange finalement: l'arrangement à l'amiable proposé par Google dans le procès Lane Gift (rappelez-vous "la fraude est immatérielle"...) a été accepté par le juge selon le blog Google (InternetNews en parle aussi)

Bien sûr, il manque toujours les chiffres globaux de Google sur la fraude aux clics. Mais, après ces avancées, je suis maintenant plus optimiste sur leur prochaine publication que par le passé: j'oserais presque parier pour une première publication encore cette année...

Source: blog Media & Tech (par didier durand)

CNN intègre le journalisme citoyen avec CNN Exchange

En 2005, la collaboration entre les médias traditionnels et le "journalisme citoyen" paraissait encore lointaine. Pour d'autres (dont je fais partie depuis toujours - 2ème partie de ce billet et aussi sur pronetariat.com), elle semblait de toute façon inexorable.

En 2006, finalement, les exemples de cette collaboration se sont multipliés parmi les majors:

Et c'est sérieux: "l'UGC (User Generated Content) a le potentiel de jouer un rôle central dans le journalisme en ligne ou traditionnel" selon Mitch Gelman, senior vice président chez CNN.

Bien sûr, ce n'est pas un YouTube totalement ouvert à tout et n'importe quoi: CNN sélectionnera le contenu pour sa qualité en termes d'informations (l'utilisateur qui charge une vidéo sur le site en donne une licence d'utilisation à CNN qui décide ensuite)

L'objectif de CNN est certainement d'obtenir via ses spectateurs des images aussi exclusives que VG. En effet, lors de la récente université d'été de l'IFRA, Epsen Egil Hansen de VG a montré la photo ci-dessous (publiée dans VG): c'est l'arrivée du tsunami de Noel 2004 sur une plage de Thailande prise par un lecteur de VG en vacances là-bas qui l'a aussitôt fait parvenir à la rédaction par son téléphone mobile. Cette photo est pour moi une preuve indiscutable de la valeur du journalisme citoyen même pour les grands médias. Elle accrédite donc - si besoin était - le mouvement de CNN.

Cette photo est pour moi une preuve indiscutable de la valeur du journalisme citoyen même pour les grands médias. Elle accrédite donc - si besoin était - le mouvement de CNN.

Au fait, CNN aurait-elle regardé (et intégré) la vidéo de Chris Anderson "L'audience va entreprendre quelque chose"?

Source: blog Media & Tech (par didier durand)

En 2006, finalement, les exemples de cette collaboration se sont multipliés parmi les majors:

- VG en pionnier (en fait dès le tsunami de Noel 2004)

- Le Matin Bleu a suivi rapidement aussi en faisant appel à ses lecteurs (pour leurs blogs via le site Internet BleuBlog et pour l'édition papier)

- Reuters a aussi franchi le Rubicon après que son boss en ait abondamment parlé

Et c'est sérieux: "l'UGC (User Generated Content) a le potentiel de jouer un rôle central dans le journalisme en ligne ou traditionnel" selon Mitch Gelman, senior vice président chez CNN.

Bien sûr, ce n'est pas un YouTube totalement ouvert à tout et n'importe quoi: CNN sélectionnera le contenu pour sa qualité en termes d'informations (l'utilisateur qui charge une vidéo sur le site en donne une licence d'utilisation à CNN qui décide ensuite)

L'objectif de CNN est certainement d'obtenir via ses spectateurs des images aussi exclusives que VG. En effet, lors de la récente université d'été de l'IFRA, Epsen Egil Hansen de VG a montré la photo ci-dessous (publiée dans VG): c'est l'arrivée du tsunami de Noel 2004 sur une plage de Thailande prise par un lecteur de VG en vacances là-bas qui l'a aussitôt fait parvenir à la rédaction par son téléphone mobile.

Cette photo est pour moi une preuve indiscutable de la valeur du journalisme citoyen même pour les grands médias. Elle accrédite donc - si besoin était - le mouvement de CNN.

Cette photo est pour moi une preuve indiscutable de la valeur du journalisme citoyen même pour les grands médias. Elle accrédite donc - si besoin était - le mouvement de CNN.Au fait, CNN aurait-elle regardé (et intégré) la vidéo de Chris Anderson "L'audience va entreprendre quelque chose"?

Source: blog Media & Tech (par didier durand)

Inscription à :

Commentaires (Atom)