Au des chiffres que j'ai déjà publié (1 milliard de dollars en 2006), la SEO est de toute façon un sujet de plus en plus important pour les entreprises! Et ces chiffres n'incluent même pas le travail interne...

Pour maximiser l'expérience acquise et avoir un maximum de retours les plus variés, je mets en service les mêmes outils sur ce blog.

Voici mon expérience!

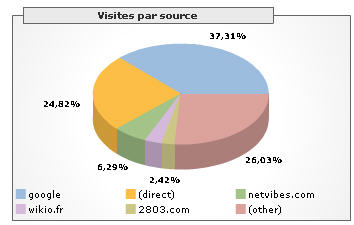

Une bonne partie du trafic de Media & Tech (hors RSS) vient de recherches sur Google: 37% à en croire le graphe ci-dessous.

[Ce graphe est la journée d'hier vue par Google Analytics que j'ai aussi mis en service sur Media & Tech - je reviendrai sur cet autre service Google]

Cette part dominante de Google n'a rien de spécifique à ce blog quand on voit les parts de marché de Google dans le domaine de la recherche....

Les recettes Google sont toujours à 99% publicitaires et le search est toujours le coeur de la stratégie Google (voir le graphique de ce billet). Ce dernier a donc tout intérêt à donner un peu (pas forcément le maximum...) de transparence sur la manière dont ses robots de crawling du web fonctionnent afin de permettre aux webmasters d'améliorer le référencement de leur site.

C'est ce qu'explique la page à propos de Google Sitemap sur google.fr (extrait repris ci-dessous).

Afin de ne pas être trop long aujourd'hui, je ferai plusieurs billets sur Google Sitemaps, mais je commence aujourd'hui par l'information qui me paraît la plus intéressante dans les statistiques de Sitemap pour les gens du marketing:

Sitemaps livre 2 tables similaires mais très complémentaires:

La première donne les meilleurs positionnement (rang) de mes billets dans la liste de réponses données par Google sur les mots de la requête

La seconde donne le rang de ces mêmes billets lorsque cette fois il y a eu clic sur ledit billet correspondant aux mots-clés de recherche

La seconde donne le rang de ces mêmes billets lorsque cette fois il y a eu clic sur ledit billet correspondant aux mots-clés de recherche Pour ces 2 tables, on peut faire varier le type de recherche (blog, mobile, générale, etc...) et le site Google interrogé (google.com, google.ch, google.fr, google.be, etc....) .

Pour ces 2 tables, on peut faire varier le type de recherche (blog, mobile, générale, etc...) et le site Google interrogé (google.com, google.ch, google.fr, google.be, etc....) .Pour ceux qui veulent suivre le positionnement de leur site web chez le plus grand "routeur" de trafic de l'Internet ainsi que l'activité de clics autour de leurs pages chez Google, c'est donc déjà une vraie mine d'information! (inaccessible sans Google Sitemap...)

Encore un petit manque à mon goût: on peut descendre les tables vers un tableur mais un accès programmatique (API) et plus souple et plus vaste sur d'autres croisements de données serait encore plus efficace!

En conclusion, je suis très intéressé par vos avis sur Google Sitemaps pour ceux qui l'utilisent pour leur blog ou des sites professionnels. Je republierai ensuite très volontiers pour la communauté!

Extrait la page Google.fr:

Découvrez votre site tel que le voit Google et diagnostiquez les problèmes potentiels.

La première étape dans la procédure d'amélioration de la visibilité de votre site sur Google consiste à comprendre comment nos robots explorent et indexent votre site.

- Informations sur l'exploration : Vous avez la possibilité de vérifier que nous avons accès à votre site et de connaître la date de la dernière exploration par le robot Googlebot. Vous pouvez également consulter les URL qui ont posé problème lors de l'exploration et les raisons de cet échec. Vous êtes ainsi en mesure de résoudre tout problème qui pourrait nous empêcher d'indexer l'ensemble de vos pages.

- Validation du fichier Robots.txt : Vérifiez si nous rencontrons des problèmes avec votre fichier et, le cas échéant, faites des essais de modifications avant de le modifier sur votre serveur.

- Contenu du site Web : Découvrez le contenu le plus consulté de votre site, ainsi que les termes utilisés par les autres sites dans leurs liens vers vos pages.

Découvrez les performances de votre site

La seconde étape consiste à comprendre l'origine du trafic vers votre site.

- Requêtes les plus fréquentes : Découvrez les requêtes ayant généré le plus de trafic vers votre site et le positionnement de votre site dans les résultats de recherche. Vous comprendrez ainsi comment les internautes accèdent à votre site.

- Indexation des informations : Découvrez comment votre site est indexé et les pages incluses dans l'index. Si nous constatons une infraction dans votre site, nous vous donnons la possibilité d'y remédier et de faire une demande de réintégration.

Source: blog Media & Tech (par didier durand)

10 commentaires:

Pour ma part, je trouve dommage de ne pas pouvoir "choisir" les mots clés que l'on souhaite suivre...

et franchement dit, ca ne remplace pas du tout un vrai module de statistiques interne à son site qui enregistre les mots clef avec lesquels les gens arrivent sur son site web.

Je trouve les statistiques proposées par sitemaps un peu plus qu'approximative... c'est dommage...

Le mieux pour le SEO, est encore d'optimiser au maximum son site pour les mots clef que l'on désire utilsier en référencement naturel, puis de faire des vérification "a la mano" sur google, les vérife c'est pas dur à faire... on tape le mot clé... si on est en 1ère position on se met 20/20 et on enlève un point par position... mdr... 10 résults par page en top de 3ème page ca revient à faire un 0/20 pas mal comme système de notation non ?

Perso, j'utilise pour mes sites un petit cocktail constitué de :

- Google Analytics parce que les tags c'est bien pratique et comme en plus c'est gratuit et complet...

Très utile pour l'analyse sur une plage de temps.

- Google Sitemaps pour la fonctionnalité dont tu parles. Bien pratique pour visualiser sur quels mots clés tu apparais mais on ne te clique pas forcément.

Je regrette que cela ne soit pas plus étendu, et même qu'il n'existe pas un service qui permette de lister toutes ces apparitions ou au moins les 500 premières.

- Mybloglog pour les blogs, car leur outils de suivi est plus accessible pour les referers en suivi journalier.

- Feedburner pour les flux RSS.

- logs en dur (vu avec webtrends log analyser 5.0 (licence payée)) parce que pour certains clients, j'ai besoin de connaître le cheminement exact et tout ce qu'ils regardent.

Bonjour Charles,

On est kif-kif:

- Je suis fan de Analytics

- pour ce blog, j'utilise aussi Feedburner ainsi que Mybloglog

- pour mes activités pros, également Webtrends

Merci de ton input (je la publierai d'ici 2-3-j avec toutes les autres)

didier

Bonjour Luc,

Cool ton idée de notation!

Un point: il y a quand même des infos via Sitemaps que tu n'as pas avec une analyse des mots clefs pour arriver chez toi: c'est justement les pages qui sont mises en résultats mas jamais cliquées.

a+

didier

Bonjour,

Je ne suis pas sûr de bien comprendre à quoi correspondent les deux listes de Sitemaps...

La 1ère est le Top 20 des requêtes Google, pour celles qui renvoient Media & Tech dans la liste de résultat, c'est ça ? Mais jusqu'à quelle position ? Si Media & Tech est en position 315.269 sur la requete "sexe" (exemple !), ça figure dans la première liste du rapport ou pas ?

Si j'ai bien compris, la 1ère liste se borne à indiquer comment se situe Media & Tech sur les requêtes vedettes de Google... Me trompé-je ?

Exemple : si je tape "Didier Durand", je peux cliquer sur [J'ai de la chance] sans aucun risque de me tromper. Les rapports de Google Sitemaps n'en disent rien car "Didier Durand" n'est sans doute pas dans le Top 20 des requêtes Google.

L'information contenue dans ces deux rapports de Google Sitemaps est donc bonne à prendre à condition de pouvoir préciser quelle est la part du trafic issu du Top 20 des requêtes générales de Google...

Quelquechose me dit que l'essentiel du trafic doit provenir plutôt de la longue traine qui est derrière ce Top 20, non ?

Bonjour Pierre,

Il s'agit des Top 20 queries qui retournent un résultat de mon blog

Par ex, c'est donc visiblement sur "si cétait à refaire" que je sors le plus souvent. mais, cette requête ne fait pas partie du top 20 absolu de Google.

Voici un copier/coller du help de Google Sitemaps "Top search queries are the queries on the selected search property [ici google.fr] that most often returned pages from your site."

voilà, j'espère que c'est plus clair.

cordialement

didier

Merci Didier pour cette précision mais quelle est la limite qui filtre le rapport ?

Sur ce Top 20, Media & Tech apparait au pire en 86èeme position. Il n'y en a que 3 qui renvoient un ordre supérieur à 10.

Or, quand vous lancez une requête, Google vous signale des centaines de milliers de réponses !

Donc je suppose que Google filtre son rapport Sitemaps en dessous d'un certain énième...

D'où ma question sur la 'longue traine'.

Pierre,

je en comprends pas votre question: il n'y a pas de filtre.

Google prend dans toutes les requêtes qui lui arrivent les 20 premières (par rapport à son classement global volume) qui lui font sortir qch de mon blog. C'est tout!

Donc, c'est ce qui est le plus à gauche de la Longue Traîne qui sort d'où "si c'était à refaire" plutôt que M&T ou "didier durand": beaucoup plus de francophones posent la question "si ..." à Google que les 2 autres.

Cela me paraît très logique!

Il me semble que vous faites un confusion entre le RANG de mes meilleurs résultats sur Google et le VOLUME (NOMBRE)des requêtes d'un certain type posées à Google.

didier

Didier,

Visiblement, quelque chose m'échappe même si je ne pense pas confondre le rang d'un site et la fréquence d'une requête.

Prenons un exemple :

D'après les comparateurs de mots clé, CHIRAC a une fréquence de requête beaucoup plus élevé que CRAIGLIST (plus de 10 fois plus pour le mois de septembre, selon Inventory par ex.)

Or, Google indexe aussi bien CHIRAC que CRAIGLIST sur votre site. Voir par ex :

http://www.google.fr/search?num=100&hl=fr&q=chirac+site%3Amedia-tech.blogspot.com&btnG=Rechercher&meta=

http://www.google.fr/search?num=100&hl=fr&q=craiglist+site%3Amedia-tech.blogspot.com&btnG=Rechercher&meta=

Au moment où je fais le test, je trouve 17 occurrences 'Craiglist' pour 40 occurrences 'Chirac'

Comment expliquez vous que Craiglist apparaisse en tête du rapport Top 20 de Google Sitemap alors que Chirac n'y apparait pas du tout ?

De là mon hypothèse que Google pose un filtre sur le rang...

Ou bien j'ai rien compris :o)

Bonjour Didier,

Ayant retrouvé ta trace aujourd'hui par la filière ESIEE, je profite de ton billet pour apporter quelques infos sur le sujet.

Hasard du calendrier, je viens d'ajouter Google SiteMaps à mon site professionnel le 1er nov... http://www.isotools.com

Je l'ai fait avec notre logiciel Isotools Studio et une extension développée par un partenaire : http://www.ld-services.net/show_room.php

Comme tout est codé en XML, c'est assez simple.

A propos du référencement naturel, je te conseille un doc que j'ai publié avec un spécialiste du sujet et de linguistique : http://www.isotools.com/news000146dd.php

L'optimisation est à construire sur le choix d'un mot clé par page, pas plus. Il faut de plus faire correspondre le Title, la Description, le contenu et l'identifiant de page.

Avec cela, les pages remontent assez bien.

Google Sitemaps doit encore permettre d'améliorer le PageRank.

Amusant : voici un site de l'un de nos clients qui n'a jamais rien fait en référencement et qui obtient un pagerank de 8/10 par la simple constitution homogène de son site http://www.isourcegestion.fr

Il faut donc comprendre que la qualité du code produit dans les pages web joue un rôle non négligeable.

A bientôt sur les ondes,

Jean-Marc Salaün

jm.salaun@gmail.com

Tel +33 1 53 62 64 99

www.isotools.com

Enregistrer un commentaire